- 05/18

- 2021

-

QQ扫一扫

-

Vision小助手

(CMVU)

1.设计下一代面向服务的E/E架构

当今汽车上多达数以百计的ECU(电子控制单元),MCU(微控制处理器单元)及其上面运行着的大量的嵌入式软件代码,以及复杂的CAN、LIN、FlexRay等整车通讯网络决定了汽车不同于其他的IOT设备或智能手机。汽车上的电子电气架构一直在朝着为智能化和体验服务的方向在演化和迭代,只是这个过程相比消费电子行业需要更长的时间。现今主流的汽车电子电气架构发展的三个阶段:以控制器为中心的阶段、域控制器阶段、中央计算机阶段。

图1 汽车计算环境未来架构

1.1 OEM视角的SOA和中央计算平台

SOA和中央计算平台的优点:

硬件和软件解耦 (面向不同的客户和具体的服务需求)

服务的重新使用和模块化(构建块)

简化基于软件的创新方式

定制化,新业务模式,借助软件更新

图2 SOA和中央计算平台

SOA和中央计算还能够转变传统的通信模型:借助多平台中间件(例如SOME/IP)、网络配置更加灵活和自动化、保障网络数据传输的QoS。

1.2 服务和应用程序的层次结构

服务执行方式有以下几种:

用于专用电子控制单元,例如:摄像头和雷达

用于基本服务的区域控制器,例如:传感器数据处理

用于组合服务的高性能计算ECU,例如:ADAS

用于云端,例如:信息娱乐

用于基础架构,例如:速度限制

这些服务可分组使用,以定义可重复使用的软件组件或完整的虚拟ECU。

图3 车内SOA

SOA用例1:Lighting Service

当数百个服务生成的数千个数据流争夺网络资源时,配置通信服务如下图所示:

图4 Lighting Service

SOA用例2:智能传感器融合用例

智能传感器:将模拟数据转换为服务通信(例如摄像头和雷达) 使用(硬件或软件中的)CBS整形解决方案,预整形脉冲信号

图5 数据转换

2.E/E架构:拓扑、协议栈、服务特征及其QoS要求

2.1 E/E架构的以太网仿真模型

下图是RTaW-Pegase中建立的以太网仿真模型,其中包括:

1台中央计算机(物理计算单元:Physical Computing Unit)→ PCU服务器组合服务及应用程序;

17个以太网上的ECU,包括3个前置/后置摄像头、2个雷达、3个显示屏、车外模块+专用ECU,例如用于PIU后的5个拆分CAN上的I/O和底座;

5个区域控制器(物理接口单元:Physical Interface Units)→PIU服务器基本服务。

图6 以太网仿真模型

2.2 用于流量分段和整形的协议栈

图7 OSI七层模型

TCP:可靠且分段的传输,但不是实时的;

SOME/IP TP:可预测时序和分段传输,但没有整形功能;对不使用SOME/IP TP的服务器,将服务器报文划分为多个Events可能是一种解决方法;

CBS:流出端口中的存储有限,可能需要对发送端通信堆栈中的软件进行其他整形,但尚未有标准解决方案。

2.3 通过服务配置TSN QoS机制

在配置时应确保所有流(不仅是服务)都满足其时间限制

图8 请求-响应通信

服务的配置挑战:

请求-响应处理的截止时间,不仅是单独传输

一些报文和typ. resp.可能需要分段和整形

在大量数据流传输时需要一个自动化处理的模型

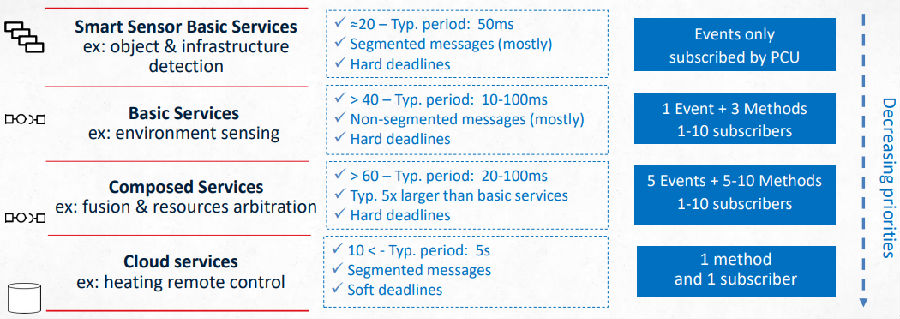

2.5 服务的特性

图9.服务特性

单独一项服务可以产生大量流量,例如,组合服务的100个单播流和5个多播流可为10个客户提供10种方法和5个事件。

图10.与服务无关的流量

3.针对服务的优化TSN配置,最大化网络容量并减少内存消耗

3.1 过载分析

图11 超载网络所占百分比与服务数量的关系

网络过载意味着一个或多个连接的负载高于100%,没有TSN协议能满足其时序约束,从过载分析图我们可以得知:

超过75个服务(3920个流)上10%的网络超载

建议无论采用哪种TSN策略,此架构最多支持60-80个服务

连接:从CGW到PCU2。将其切换到1Gb/s增加网络容量

3.2 手动配置

手动配置时流量优先级:

TSN机制:优先级、无整形

根据截止时间手动调整流量分类:紧急服务的截止时间应小于10ms

图12 分类与优先级

图13 截止时间与数据流数量的关系(优先级:5)

整形对于ADAS服务的数据流传输几乎没有作用:因为ADAS服务为低优先级的数据流,且对不分段的报文包进行整形并没有多大用处;另外抢占式处理的机制也是无效的,因为超过截止时间的数据流都不会是高优先级的。由上图可以得知,数据流数量越多,相应在最坏情况下传输的截止时间也会不断缩短。

3.3 基于算法的配置

有简洁优先级算法的流量优先级

TSN机制:优先级机制,无整形

自动化流量分类:不同类型的数据流将混合在所有优先级中

图14 分类与优先级

图15 截止时间与数据流数量的关系(优先级:6)

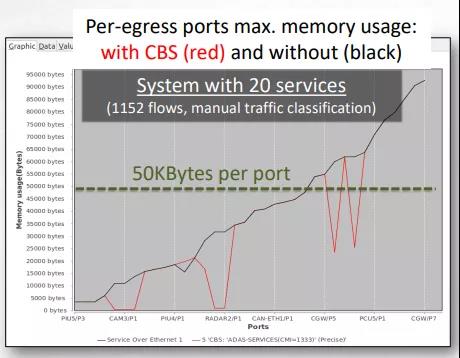

在此过程中,8个优先级的数据流全部都有传输,发现高优先级的数据流反而在截止时间之后到达;和手动配置一样,抢占式处理依然无效,这是因其受到延迟受限的低优先级数据包的阻塞,另外整形仅对内存有一点作用。整形降低内存使用的效果如下所示:

图15 每个流出端口最大内存使用情况:有CBS(红色),无CBS(黑色)

由上图可知,使用CBS减少每个设备的内存使用量最大值:97%,平均:12.3%。

- 上一条:用于疫苗瓶质量控制的智能多摄像头系统

- 下一条:机器视觉新能源方壳电池行业案例