- 08/15

- 2023

-

QQ扫一扫

-

Vision小助手

(CMVU)

随着人工智能技术的不断进步,移动机器人正朝着自动化和智能化的方向发展。为了更好地理解当今工业场景复杂、高动态的环境,移动机器人需要更强的感知能力。因此,工业级传感器选型显得尤为重要。

工业机器人可搭载的传感器包括:激光雷达、红外传感器、光电传感器、超声波传感器、磁传感器、视觉传感器等。在移动机器人发展的早期阶段,由于感知能力有限,一般被称为AGV(自动牵引车),还无法被称为机器人。它们主要依靠磁传感器或红外传感器,只能沿着固定的导轨或路线行进,智能化自然无从谈起。

随着激光雷达和3D视觉相机技术的进步,移动机器人更适合应用于复杂、柔性的工业制造和服务领域。这些机器人具备灵活的移动性、自主规划路径的能力,并支持多机在同一场景下运行,同时具有更强的环境感知和安全防护能力。环境感知能力是衡量移动机器人(AMR)智能化程度的重要指标。

自主移动机器人的智能化体现在如下几个方面:安全性、稳定性、高效性和柔性。无法达到上述几点,将难以满足工业场景对产线的需求,无法称之为智能机器人。

安全性

机器人可自主移动,载重由数百公斤到数吨,如何确保其运行安全?

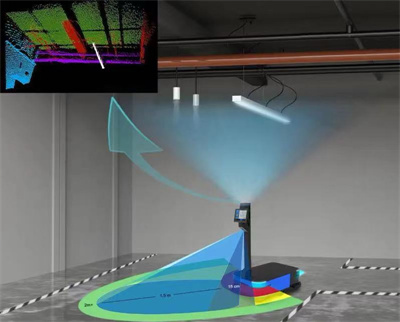

3D视觉相机可作为确保机器人运行安全的避障单元。基于TOF(飞行时间)原理的3D相机,通过发射特定波段的电磁信号,获取前方物体的点云数据,能够有效识别机器人前方的悬空障碍物和低矮障碍物,甚至是凹坑,避免移动机器人倾覆的情况出现。为此,需要研发适用于工业场景的避障相机和配套避障算法。其典型应用场景包括:识别生产线上伸出的电子屏幕、定位地面可能存在的小纸盒和凹坑、智能识别行走的人员,特别适合于人机共用同一通道的工业场景。随着数据的积累,避障算法亦逐步升级,愈发灵活。

稳定性

对于自主移动机器人而言,其定位、导航模块为自主移动的基础,也是从AGV到AMR过渡的重要标志。目前业界主流的导航方式是2D激光SLAM导航。然而,经过市场的验证,此种导航方式仍被证明有其局限性。例如,在空旷、易变和反光的场景中,2D定位信息容易丢失。

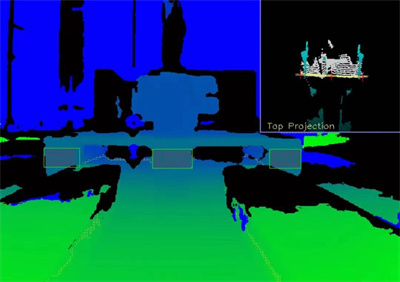

基于3D视觉的定位导航模块通过相机获取环境中丰富的三维环境图像信息和稠密的深度数据,结合自研视觉定位算法实现移动机器人的定位。与2D激光雷达相比,3D视觉信息丰富,稳定可靠,并具有更强的环境适应性。它更适用于复杂、多变和人机工厂的应用场景中,如地堆型仓库、大型空旷的车间、存在玻璃墙和玻璃门的车间等。

高效性

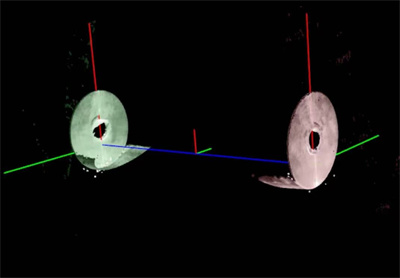

3D视觉的应用不仅限于导航和避障功能,还赋予移动机器人(如自动叉车)托盘循迹对接的能力。通过自研的3D视觉相机获取托盘的3D点云数据,并通过自研的托盘识别算法,智能识别出托盘的中心位置。集成智能对接算法,使移动机器人能够自动调整位姿,准确对接目标。通过长期的数据积累,迈尔微视自研的托盘对接算法可以自适应市面上主流的托盘类型,重复识别精度在±3mm左右,角度对接精度高达±0.2°。

除了托盘识别对接,自研3D视觉相机结合定位算法,还能提供机器人自动纠偏功能,调整机器人的对接动作,完成多种对接需求,实现毫米级精度。包括包装卷材自动上下料和锂电极卷自动上下料。

柔性

柔性制造意指对各种不同形状加工对象实现程序化柔性制造。单独的移动机器人无法体现柔性,但结合多轴机械臂和小型化的3D视觉传感器的移动复合机器人可以有效实现柔性搬运、上下料等需求。搭载在机械臂末端的3D视觉传感器,可引导机器人完成移动抓取、上下料、加工转运等一系列操作,精度最高可达0.1mm。

同时,3D信息的使用,可以有效实现防呆、安全防护等功能。这在半导体、3C等安全要求较高的领域具有异常重要的意义。

迈尔微视MRDVS专为移动机器人研发的深度视觉系统,主要包括传感器、算法两部分。传感器方面主要基于光飞行时间原理,通过测量主动光经目标反射后的时间差,根据光速计算目标的距离。为避免高精度的时间测量,将主动光源经过振幅调制,测量目标反射后的接收光和发射光的相位变化来间接获得光的飞行时间。基于TOF技术深度相机可以较高的帧率获取深度图像,具有很好的抗环境光干扰能力,在8米以上的距离保持较高的精度,且体积和功耗很小,非常适合用于移动平台的避障、导航定位等。

正如创始人高勇博士所期待的,“人类因为有眼睛这一重要传感器,感知环境、理解环境,并做出相应动作自然行云如水,但机器人没有‘眼睛’要做相同的动作就困难很多。迈尔微视的初心和使命,就是要解决移动机器人‘眼睛’的问题,用3D视觉赋予机器人对环境的感知能力,进而为人类提供更多服务。”迈尔微视将以传感器和算法为武器,让机器人“看懂”世界,更好的服务世界。