- 05/07

- 2025

-

QQ扫一扫

-

Vision小助手

(CMVU)

针对具有挑战性的光照条件和恶劣环境,本文提出了LIR-LIVO,这是一种轻量级且稳健的激光雷达-惯性-视觉里程计系统。通过采用诸如利用深度与激光雷达点云关联实现特征的均匀深度分布等先进技术,以及利用Superpoint和LightGlue实现的自适应特征匹配,LIR-LIVO实现了低计算成本下的最先进的(SOTA)精度和鲁棒性。

本文核心内容

我们提出了一种轻量级、鲁棒且抗光照变化的激光雷达-惯性-视觉里程计系统(LIR-LIVO),该系统利用基于深度学习的抗光照变化特征点和激光雷达-视觉深度关联,实现了低计算成本和高鲁棒性。

我们提出的方法继承了FAST-LIO2的直接法来进行激光雷达惯性里程计,通过优化点到平面的距离来实现状态估计。为了更有效地利用激光雷达点云来辅助视觉特征点的深度,我们采用扫描重组将高频、连续采样的激光雷达点云分割成与相机采样时间戳对应的独立激光雷达扫描,确保激光雷达和相机的频率一致。随后,我们应用顺序更新算法,联合使用LIO和VIO系统来更新状态。

通过将激光雷达点与视觉特征点关联起来,可以直接获得视觉特征在空间中的精确3D位置,从而无需进行视觉三角测量以及更新和维护视觉特征3D点。这种方法提高了VIO系统的效率和视觉3D点的精度。此外,所提出算法的一个关键创新在于整合了使用卷积神经网络提取的深度视觉特征,并利用了轻量级、高效且基于深度学习的特征匹配算法。这种方法在光照变化显著和快速移动的场景中表现出色,从而显著增强了在诸如激光雷达和光照条件均不佳的环境中激光雷达-惯性-视觉里程计的鲁棒性。

本文的贡献可概括为:

• 提出了一种稳健、轻量级、抗光照变化的激光雷达-惯性-视觉里程计系统,适用于激光雷达和视觉条件恶劣的环境。通过迭代卡尔曼滤波器在测量层面紧密融合激光雷达、视觉和惯性传感器,其中激光雷达扫描点云为视觉特征提供精确的深度信息。

• 该系统利用基于深度学习的Super-Point算法进行自适应视觉特征提取,以及LightGlue算法进行高效特征匹配。它们在显著光照变化下的卓越鲁棒性极大地增强了视觉惯性里程计子系统的抗干扰能力,确保在视觉条件不佳的环境中也能可靠运行。

• 视觉惯性里程计子系统设计为轻量级组件,并借助激光雷达深度关联,消除了维护和更新视觉3D地标和子地图的必要性。它仅在滑动窗口内保留有限数量的历史关键帧,以构建用于优化的重投影误差。还应用了优化的特征点深度分布来增强姿态估计。

所提出系统已在GitHub上开源。

方法架构

图2展示了我们系统的概览,该系统由两个主要组件构成:基于直接法的激光雷达模块,其与相机帧的时间同步,以及具有深度学习前端的轻量级视觉模块。

利用Sweep重组来同步激光雷达帧和相机帧的时间戳。因此,ESIKF过程通过顺序更新执行,使激光雷达更新的姿态能够作为视觉处理的高精度先验。Super-Point和LightGlue用于构建视觉前端,特征点深度直接与激光雷达点云相关联。在此过程中,对特征点的深度进行滤波,以确保深度分布均匀。对于激光雷达点云管理,我们采用与FAST-LIO2相同的策略,使用ikd-Tree。我们不是直接维护用于视觉的3D地标地图,而是将每一帧的特征点及其对应的深度存储在相应相机帧的数据结构中,同时维护一个使用滑动窗口固定相机帧数。在激光雷达和视觉中,点到平面误差和重投影误差分别用于姿态估计。

实验结果

A.评估数据集

用于性能评估和分析的数据集,包括FAST-LIVO-Dataset、R3LIVE-Dataset、NTU-VIRAL以及Hilti'22。这些数据集分为两类:第一类包含有参考地面真实值的数据集,如NTU-VIRAL和Hilti'22;第二类则没有参考地面真实值,但其轨迹的起始点和终点之间存在一致的重叠,例如FAST-LIVO-Dataset和R3LIVE-Dataset。NTU-VIRAL数据集是通过无人机采集的,而其余三个数据集则是手持采集的。

所有实验均在一台配备英特尔酷睿i7-14700K处理器、32GB内存和NVIDIA GeForceRTX 4080Super图形处理器的消费级计算机上进行。

B.基准实验

在本次实验中,我们对来自NTU-VIRAL、Hilti'22、R3LIVE-Dataset和FAST-LIVO-Dataset的20个序列进行了广泛的评估。

除了我们提出的LIR-LIVO方法外,还使用了几个最先进的(SOTA)开源算法进行比较,包括R3LIVE,一种密集直接激光雷达-惯性-视觉里程计系统;FAST-LIO2,一种直接激光雷达-惯性里程计系统;FAST-LIVO,一种快速直接激光雷达-惯性-视觉里程计系统;SR-LIVO,一种基于R3LIVE的基于扫掠重建的激光雷达-惯性-视觉里程计系统。

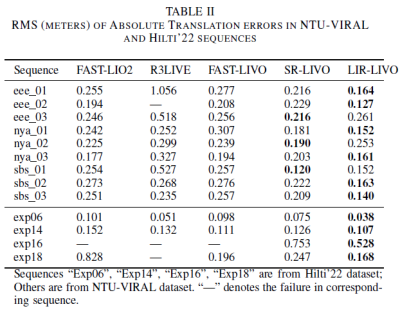

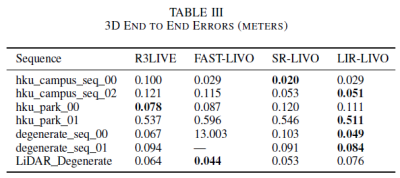

我们直接从各自的GitHub存储库下载了SOTA算法,并使用了它们推荐的室内和室外激光雷达配置。对于SR-LIVE和FAST-LIVO,我们通过引入鱼眼相机模型和新的激光雷达数据格式扩展了原始实现。此外,在R3LIVE中,我们禁用了相机内参和外参的实时在线估计,以确保所有估计策略的一致性。除了这些修改之外,所有参数,如提取的特征点数量、光流跟踪中的金字塔层级以及视觉观测的协方差保持为作者在其源代码中提供的默认配置。所有算法的结果分别在表II和表III中给出。

如表II所示,LIR-LIVO算法在大多数序列中实现了最低的均方根(RootMeanSquare,RMS)绝对平移误差,突显了其相较于其他先进方法的卓越精度。对于NTU-VIRAL数据集,LIR-LIVO一直优于FAST-LIO2、R3LIVE和FAST-LIVO等竞争对手。例如,在“eee01”序列中,LIR-LIVO的误差为0.139米,显著低于FAST-LIO2和FAST-LIVO。在Hilti'22数据集上,LIR-LIVO表现卓越,在“Exp06”序列中实现了0.038米的误差,显著优于SR-LIVO和FAST-LIVO。

这些结果表明LIR-LIVO在处理NTU-VIRAL和Hilti'22序列时具有强大的稳健性和准确性,在各种环境中始终超越现有方法。在Hilti数据集的比较中,由于缺少外部IMU配置,R3LIVE被排除在测试之外。“Exp14”、“Exp16”和“Exp18”序列是在室内环境中记录的。如图5所示,Hilti'22数据集存在光照条件差的问题,这进一步加大了视觉前端和位姿估计的难度,导致FAST-LIVO和SR-LIVO表现不佳,在具有挑战性的序列上出现失败。

表格III部分总结了不同序列中的3D端到端误差(米)。SR-LIVO在“hku校园序列00”中误差最低,而LIR-LIVO在“hku校园序列02”中表现更优,误差为0.051米,并且在“退化序列00”中表现出色。FAST-LIVO在“退化序列00”中表现不佳。R3LIVE在“hku公园00”等较简单的情况下表现良好,但总体上不够稳定。LIR-LIVO在大多数场景中都表现出较强的鲁棒性,尤其是在具有挑战性的条件下。

C.时间消耗分析

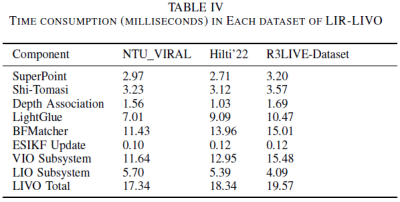

如表IV所示,LIR-LIVO在各数据集上均表现出高效的时间消耗,其中VIO子系统对计算时间的贡献最大,而LIO子系统则保持高效。尽管前端采用了基于深度学习的方法,但表IV显示,在速度方面借助GPU加速后,其效率高于诸如Shi-Tomasi角点检测和暴力匹配器等传统方法。在VIO子系统中,视觉前端几乎占了总计算时间的三分之二。大部分时间都消耗在滑动窗口中的帧与新帧之间的特征匹配上,这主要取决于滑动窗口的大小。表IV中的时间消耗是使用大小为5的滑动窗口测量得出的。

D.深度分布影响

在NTU-VIRAL数据集上进行了消融研究,以评估强制视觉特征点具有均匀深度分布的影响。具体而言,对每一帧中与深度相关的特征点进行排序,并均匀下采样至50个点。这种策略显著降低了ESIKF更新中涉及的矩阵维度,从而提高了计算效率。实验结果如表V-C所总结,表明该方法优于原始方法,在七个序列上均有改进。

总结

本文提出了LIR-LIVO,这是一种新型的激光雷达-惯性-视觉里程计系统,旨在解决激光雷达信号退化和复杂光照条件下的环境挑战。所提出的系统结合了具有均匀深度分布的激光雷达深度关联、基于深度学习的视觉特征以及轻量级视觉子系统,以实现高效且稳健的状态估计。在基准数据集上的全面评估表明,LIR-LIVO在激光雷达退化环境中表现更优。

(文章来源于互联网,如有侵权,请联系删文)