- 01/19

- 2021

-

QQ扫一扫

-

Vision小助手

(CMVU)

iPhone 12 Pro自发布以来,其搭载的激光雷达LiDAR的作用已经进行了一波科普,不过却一直缺乏实际的应用体验,现在到手的用户多了,各个社区开始通过实际使用来体验LiDAR的应用。那么,这种应用有什么用呢,仅仅是出于消费者的娱乐还是将会对某些领域/产业带来深刻的影响和变革,又或者可能对未来有什么展望呢?本文通过实际应用图片与视频的体验来给我们打开一扇激光雷达在消费领域的应用之窗,透过这扇窗户也可能看到未来的下一代智慧终端的身影......

LiDAR是Light Detection and Ranging的缩写,亦即激光探测与测距。这是一种飞行时间深度传感器,它主要是发射激光,接收从目标反射而回的信号,然后计算激光脉冲的传播或飞行时间来测量距离。通过精确的计时,相关信息可用来判断每个点的深度。丰富的深度信息将能用于环境3D映射,导航和AR效果等各种不同的用例。

扫描光斑

这种光斑扫描看似无聊,实际上是体现了iPhone 12 Pro上的激光雷达在一定底噪下的扫描能力。

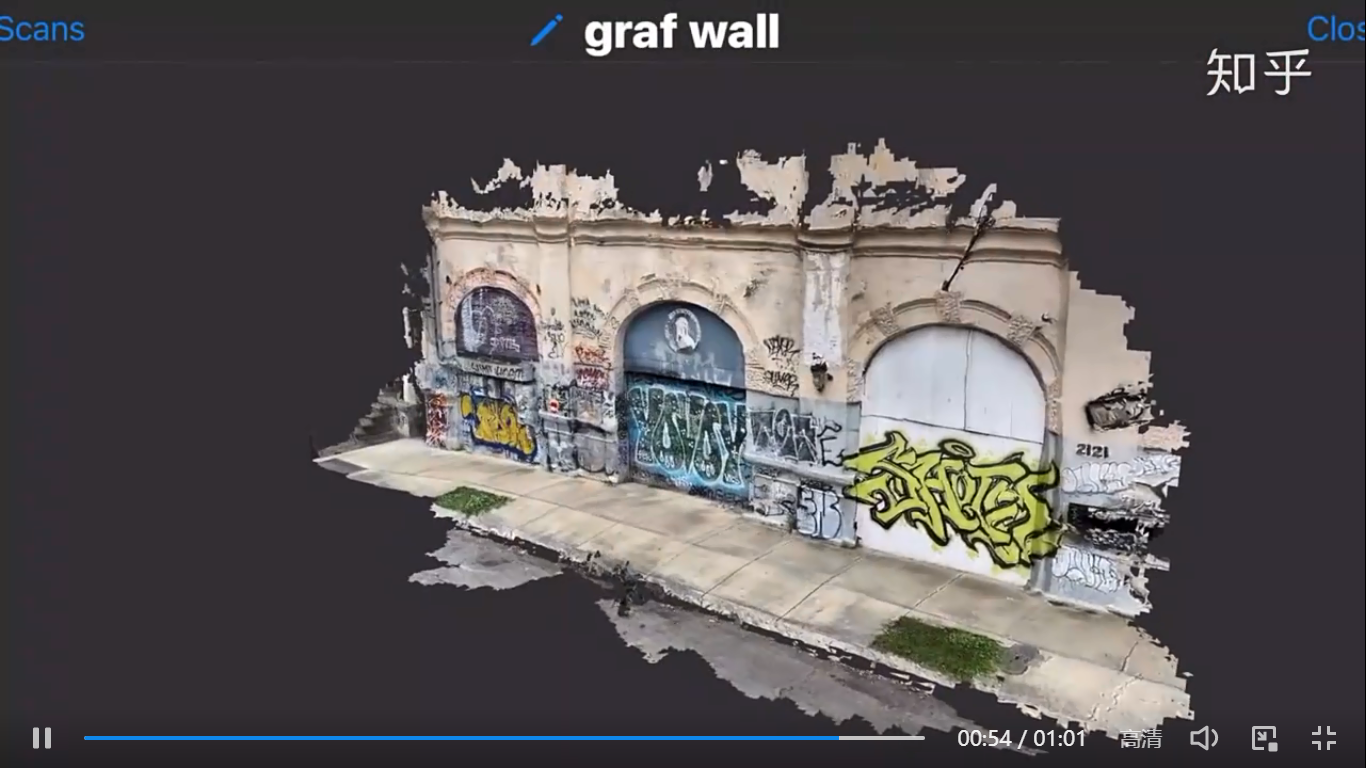

3D扫描

激光雷达可以用来对3D对象进行实时快速建模,然后可以直接使用模型自由移动和使用在其他场景,或在上叠加内容。这可能是图像建模领域的下一波应用,比如作用于家庭装修,甚至是社交媒体和新闻业领域。

下面是知乎网友@HapPiness568的视频截图

显示了建模的全过程,非常快速。

这是汽车的建模

这种捕捉3D数据并公开分享的能力可以让搭载LiDAR的智能手机和平板电脑成为3D内容捕捉工具。LiDAR同时可以在不使用摄像头元件的情况下来获取对象和空间的测量值。

从这个意义上说,iPhone12 Pro和iPad Pro就像是没有头戴部分的AR头显……它们将为苹果自己生产的AR眼镜铺平道路,这也可能是下一代智慧终端的雏形。

AR虚实遮挡

对于搭载了激光雷达扫描仪LiDAR的iPhone 12 Pro和iPhone 12 Pro Max等设备,苹果表示这意味着手机能够支持“即时AR”。因为所述组件能够以相当于“拍摄一张照片”的方式捕捉深度信息,无需任何手机移动,无需跨时间对比图像。

这款组件内置的高级场景理解功能允许Depth API利用关于周遭环境的每像素深度信息。当与场景几何体生成的三维网格数据相结合时,通过启用虚拟对象的即时放置并将与物理环境无缝混合,深度信息可以令虚拟对象遮挡更为逼真。这可以支持应用程序部署全新的功能,比如更精确的测量和将效果应用到用户环境中。

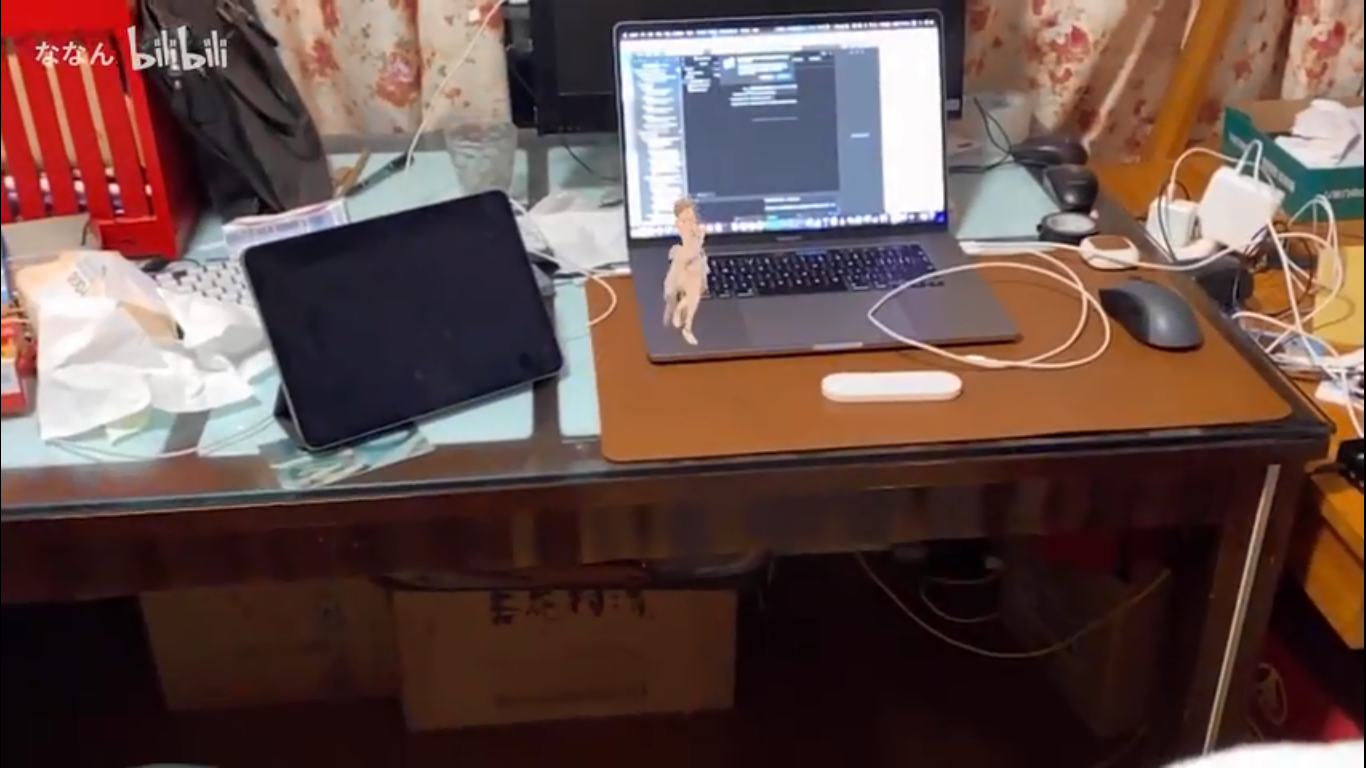

上面这个是利用iPhone 12 Pro的激光雷达自制AR小姐姐在键盘桌面上跳舞,手办她动起来了!

下面这个视频来自Sketchfab首席执行官阿尔班·德诺耶尔(Alban Denoyel)。我们可以看到,德诺耶尔用手上下左右地围绕这个虚拟瓜果移动,并且偶尔会变速,而虚拟瓜果可以相当逼真地藏在手的后面或者挡在手的前面。虚实切换非常无缝和流畅。

又如下面这个来自Patched Reality首席执行官帕特里克·奥肖内西(Patrick O’Shaughnessey)的演示视频,一个虚拟球体正沿着旋转滑梯滑下。令人感到惊讶的是,虚拟球体就如同真实球体一样,能够恰如其分地顺应遮挡而在视图中消失和出现。

人物识别

基于LiDAR的原理,iPhone 12 Pro等设备同样可以用于进行人/物识别,并以多种不同的方式向用户提供反馈。

首先,设备可以告诉用户周遭环境是否存在人与物。如果存在,它能够以英尺或米表示距离,并在用户或对象接近或原理时定期更新。

其次,它允许用户设置与特定距离相对应的音调。例如,如果用户将距离设置为1米,当彼此距离超过阈值时,用户就会听到一个音调。

显然,这样的功能将会对视障用户带来重要帮助,尤其是盲人。

另外,这对于未来的AR眼镜同样非常有用,例如AR导航。AR眼镜可以利用LiDAR获取关于周遭环境对象的精确距离信息,并以合适的数字影像和声音来提高感知判断能力。