- 04/25

- 2025

-

QQ扫一扫

-

Vision小助手

(CMVU)

摘要:通过发掘深度信息与子孔径图像邻域像素间的高度相关性,提出了一种基于邻域像素注意力机制的光场深度估计方法。首先根据光场图像的数据特性提出了一种邻域像素注意力机制,该注意力机制考虑了不同子孔径图像在同一邻域间的极几何关系,能够增强网络对遮挡像素的感知能力。其次基于注意力机制设计了一个光场子孔径图像序列特征提取模块,该模块通过三维卷积将相邻序列图像上的特征编码到特征图上,并通过注意力机制增强网络对光场图像极几何特征的学习能力。最后联合邻域像素注意力机制和特征提取模块设计了一个多分支的全卷积神经网络,该网络使用部分光场子孔径图像序列即可估计图像的深度特征。实验结果表明,所提方法在均方误差(MSE)和平均坏像素率(BP)指标上总体表现优于其他先进方法,同时得益于高效注意力机制的加入,与其他先进方法相比所提方法运行速度最快。

关键词:光场图像,深度估计,邻域像素,注意力机制,神经网络

引言

光场(Light field)是一种空间中光线集合的完备表示,能够描述空间中任一条光线在不同时间下的位置、角度和波长信息,这为深度估计提供了大量的线索。但是整个光场的数据难以采集且数量庞大,Levoy等考虑到目前传感器的限制,将自由空间中的光场简化为四维,提出了光场双平面模型;基于该模型,Ren等在常规相机的主透镜和感光元件之间放置一片微透镜阵列,实现以常规相机的体积来采集双平面光场图像,为光场成像技术的广泛应用奠定了基础。作为一种高效的被动深度估计方案,光场深度估计已经被成功应用于姿态估计、显著性检测、三维重建、粒子图像测速等领域。尽管光场数据隐含了深度信息,但是从光场图像中提取深度信息仍面临精度低、速度慢、遮挡场景误差大等问题。

现有的光场深度估计方法大致可分为基于优化与基于学习两种:1)基于优化的方法主要依靠人为构建成本度量函数并计算出图像大致的深度图,再利用全局优化、局部平滑等算法对深度图进一步优化以提高得到的深度图的质量。Yu等[10]将三维双线性子空间映射到线性约束并使用LAGC(Line-assisted graph-cut)算法进行立体匹配。Tao等提出使用MRF(Markov random fields)框架融合离焦线索和对应视差的线索来估计深度,并额外引入阴影线索用于改善物体的形状细节。Zhang等借助在对极平面图像(Epipolar plane image,EPI)上构建旋转平行四边形算子(SPO)来测量极线的斜率。Johannsen等采用了EPI块来构造EPI斜线字典,并使用各向异性平滑对结果进行优化。基于优化的方法在纹理明显且连续的情况下,效果较好,但在受遮挡或噪声影响时,该类方法难以获得准确的深度,同时还存在耗时长的问题。2)基于学习的方法是利用卷积神经网络强大的特征提取能力,放弃手动设计匹配模式而让网络学习出所需的拟合函数,实现端到端的深度图预测,这也是目前光场深度估计的主要研究方向。Heber等建立了一个编码-解码与变分优化相结合的U型网络,该网络使用了3D卷积来提取空间信息和图像序列信息,但没有考虑到光场数据中存在的冗余,导致算法计算量大、运行速度慢;Shin等在光场的子孔径图像中根据极几何线索使用了4个方向的图像,最后通过聚合网络来合并特征,但没能充分挖掘不同通道邻域像素间的相关性,导致深度估计的精度较低;Tsai等考虑到光场图像中存在的冗余,引入注意力机制对子孔径图像赋予不同权重并构造了代价体(Cost volume)进行深度匹配,但是该结构需要大量的内存来存放代价计算的结果,后续的视差回归也导致算法运算缓慢;Wang等引入膨胀卷积以构造视差匹配代价体,并使用了一种像素调制方法解决不同子孔径图像中存在的遮挡问题,但该调制方法对遮挡像素的建模仍不够充分。由上述文献可知,基于学习的方法仍存在以下挑战:场景中的遮挡导致了光场EPI极线不连续,使得遮挡处的深度预测结果不可信;光场深度估计需要进行亚像素层面的预测,现有方法的性能和运行速度仍有待提升。

针对上述挑战,通过分析光场图像特性,本文提出一种基于邻域像素注意力机制的光场深度估计方法:1)针对光场深度估计任务的特性以及子孔径图像序列的特点,利用光场中某一像素点的深度信息与该像素点周围有限邻域像素点的相关性,提出邻域像素注意力机制Mix Attention,联合空间与通道注意力高效地建立了特征图与深度的关系,提高了光场深度估计的精度,并使网络具有一定的抗遮挡能力;2)基于该注意力机制提出一种序列图像特征提取模块,利用三维卷积将子孔径图像序列包含的空间与角度信息编码到特征图中,并使用Mix Attention调整权重;3)提出一种多分支深度估计网络,使用光场部分子孔径图像作为输入,实现了任意尺寸光场图像快速的端到端的深度估计。运用所提方法对光场数据集New HCI进行测试,验证了该方法在坏像素率(BP)、均方误差(MSE)和计算时间3个性能指标上的优越性。

基于邻域像素注意力机制的光场深度估计方法

光场子孔径图像分析

光场双平面模型用两个相互平行的平面来表示四维光场,通过双平面的架构来表述光场的空间分布和角度分布信息,即L=L(u,v,s,t),式中u、v 和s、t分别表示光线穿过两个平面的空间坐标。

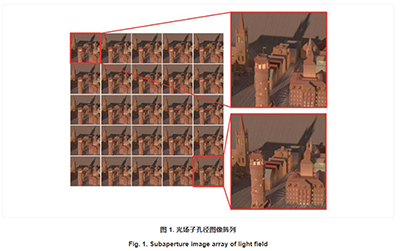

子孔径阵列图像可以通过微透镜、相机阵列等方式获得,是双平面模型下光场图像数据可视化的表示形式。子孔径阵列在获取的过程中固定了相机平面的两个坐标,更侧重于反映光线的空间分布信息。通过固定相机平面位置(u,v),令u=u*,v=v*,则L(u*,v*,s,t)可表示在视点位置(u*,v*)处对应的图像(s,t),光场数据以子孔径图像阵列的形式实现可视化,如

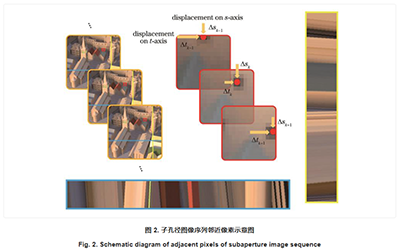

现有的基于子孔径图像的深度估计方法,没有考虑子空间图像间的邻域像素相关性,这使得深度估计算法不能充分提取图像特征,并且难以排除场景中的遮挡对目标像素点的干扰。

邻域像素注意力机制Mix Attention

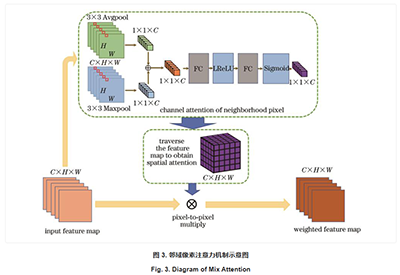

目前,注意力机制已被应用于光场视觉,但通用的注意力机制得到的注意力权重都是逐通道或逐像素的,并没有关注到像素点在不同特征图上的邻域。由于光场子孔径间的基线较短,光场中心视角中像素点的深度信息几乎只与该像素点在其他光场视角上同一位置周围有限邻域的像素点有关。基于上述原因,提出了一种基于邻域像素的注意力机制Mix Attention,如

对于一组特征图上位置(x,y)的一组像素

取其3×3邻域做平均池化和最大池化操作。平均池化聚合了邻域包含的空间信息,当场景存在遮挡时,该操作有助于特征图像剔除无关像素;最大池化能够捕捉到对应于卷积核的判别性特征,使网络能够判断不同特征图中极线的走向,

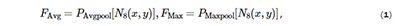

式中:FAvg和FMax分别表示平均池化和最大池化操作得到的结果;PAvgpool和PMaxpool分别表示平均池化和最大池化操作;N8(x,y)表示像素点(x,y)的8邻域。将两种池化操作得到的结果相加再经过一个两层的多层感知机MLP(Multi-layer perceptron;MMLP),得到该组像素的权重为

使用上述步骤遍历整幅特征图就得到了全图注意力

邻域像素注意力机制Mix Attention的计算过程可以表示为

式中:W1,W0∈RC×C为多层感知机的权重;fAvg和fMax分别为对邻域进行的平均池化和最大池化操作;σ为Sigmoid激活函数。从式(3)可以看出,Mix Attention在像素邻域层面上为通道注意力,遍历整幅特征图得到的是空间注意力图。

对于特征图边界上的像素点,采取零填充的方式进行池化操作,这在一定程度上会影响注意力模块的结果,所以训练时使用较大尺寸的图像块可以减少误差。由文献可知,加一层用以降维的全连接层不能提升注意力模块的表征性能,反而会导致网络性能下降,因此没有使用Bottleneck,而是利用所提方法设计的邻域像素注意力机制Mix Attention中的多层感知机进行降维。通过有效利用邻域信息,该邻域像素注意力机制Mix Attention所获得的注意力仅取决于目标点周边的像素,能够最大程度地挖掘光场的子孔径图像间的极几何信息。

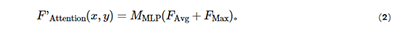

序列图像特征提取模块

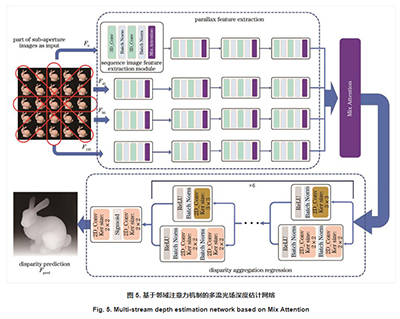

由于所提网络使用的是光场子孔径图像序列,为了让注意力模块能够感知到不同子孔径图像上的特征信息,提出一种利用三维卷积编码相邻子孔径图像序列的特征提取模块。首先使用“3D卷积-批归一化-3D卷积-批归一化-激活函数”结构将相邻图像的信息编码到特征图中,对于编码产生的多组序列特征图,采用加权融合的方式将每组序列特征图融合为单幅特征图,该权重由网络自适应学习得到。再对融合后的特征图进行Mix Attention注意力计算即可得到对应每组特征图的注意力,流程如

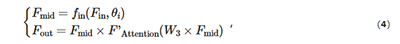

该模块的输入为一组或多组序列图像,提取出的特征为多组不同通道的序列图像,该模块可表示为

式中:Fin、Fmid、Fout分别表示输入特征图、中间编码特征图、模块输出特征图;fin表示特征编码模块;θi表示特征编码模块中的可学习参数;W3表示每个通道加权融合的权重。

基于邻域注意力机制的多流光场深度估计网络

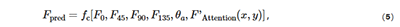

对于4个支流中从不同方向输入的光场子孔径图像堆栈,首先使用序列图像特征提取模块提取光场子孔径图像间的极几何信息。其次,将4个支流的特征图直接进行拼接合并,再利用Mix Attention模块筛选支流中对深度估计最有效的信息。然后,将筛选后的特征图输入聚合网络中进行视差回归,聚合网络中使用了6个类Inception的并行模块同时提取稀疏和不稀疏的特征,但没有使用零填充边缘,而是通过直接减小经过每层卷积后的特征图的尺寸以免引入误差。最后,经过一个“二维卷积-激活函数-二维卷积”模块输出深度估计结果。该网络可表示为

式中:

分析与讨论

实验数据及实验环境

采用Honauer等提供的New HCI光场数据集对网络进行训练和测试。该数据集中每幅光场图像包含空间分辨率为512 pixel×512 pixel、角度分辨率为9 pixel×9 pixel的子孔径图像。选取其中16幅光场图像作为训练集来训练网络,并应用文献的数据增强算法。本实验所用服务器搭载的型号为Intel(R)Xeon(R)Gold 6240,CPU为18核心36线程,内存为314 G,显卡为NVIDIA RTX2080Ti,并且实验采用PyTorch框架完成模型的搭建与训练。

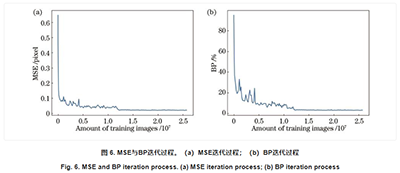

网络训练过程

New HCI光场数据集中将数据分为4类:Stratified集、Training集、Test集以及Additional集。由于Additional集包含的场景类型丰富,因此将其作为训练数据,Training集和Stratified集作为测试数据。训练在Patch-wise层面进行,这样能在增加训练图片数量的同时减少所需的显示内存,每个patch的尺寸为50 pixel×50 pixel,采用Adam优化算法,学习率从10-4衰减到10-6,在RTX2080TI显卡上训练了一周收敛。

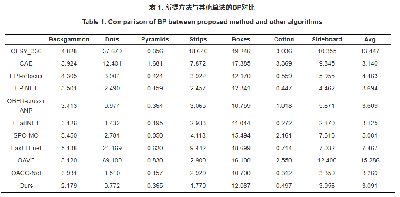

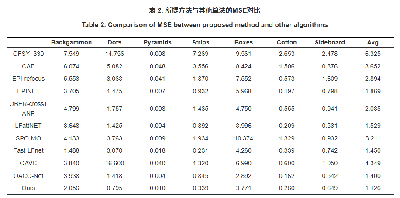

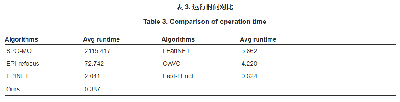

实验结果对比

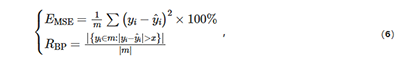

为了评估算法的实验结果,定量分析的评价指标选择了均方误差EMSE和坏像素率RBP。前者是计算预测深度和真实深度之间的MSE,可以反映深度估计结果与真值的偏离程度;后者将预测出来的视差图和真实视差图逐像素值作差,如果绝对误差小于某个阈值x就认为该深度估计预测正确,在实验中,x设置为0.07。两种评价指标的计算表达式为

式中:m

为评估所提方法的性能,选取了如下算法进行比较:基于联合深度图正则化和焦点图像堆栈对称性的OFSY_330,基于约束角熵度量的CAE,融合EPI线索和重对焦线索的EPI-refocus、EPINET,基于平滑双边滤波和给定三维点的方差度量的OBER-cross+ANP,基于旋转四边形算子的SPO-MO,基于注意力机制的视角选择卷积神经网络LFattNET,基于多视差尺度成本聚合的Fast-LFnet,基于遮挡感知代价的OAVC,基于像素调制代价的OACC-Net。

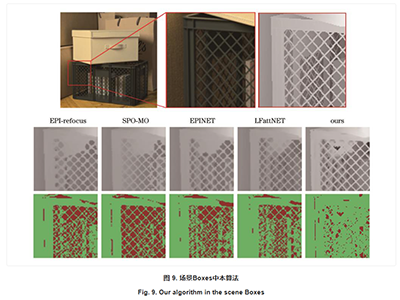

显然,所提方法的性能更加稳定,平均坏像素率和误差分别为3.091%和1.126 pixel,在大部分场景中取得了最优(加粗)或次优(下划线)的深度估计结果。

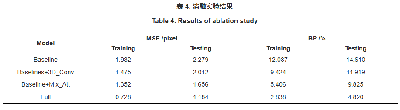

消融实验

为验证所提出的邻域像素注意力机制Mix Attention的有效性,在New HCI光场数据集上进行了消融实验。

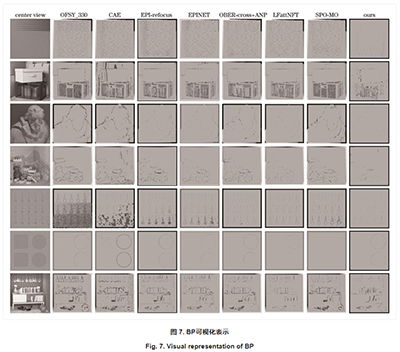

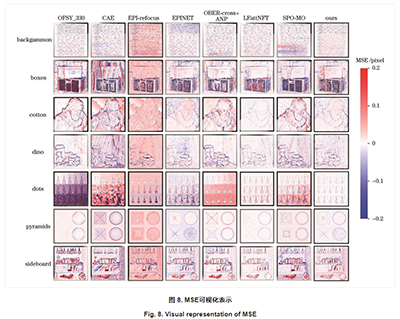

算法结果主观对比

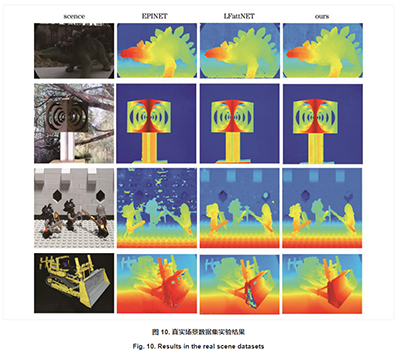

图7和

在真实数据集上用所提方法开展实验。与合成数据集相比,真实数据集会存在深度不连续、场景模糊和各类噪声等问题,从图10可以看出,所提出的方法具有很好的泛化性能,在真实数据集中得到了边缘更锐利、画面更干净的深度估计结果。

结论

针对光场深度估计任务的特性以及光场数据的特征,提出了一种邻域像素注意力机制Mix Attention,该机制可以捕捉到光场中某一像素点周围有限邻域的像素点与深度特征之间的相关性,通过对邻域的特征图进行计算,对网络中不同的特征图进行选择,提高了光场数据的利用效率。同时通过分析不同光场子孔径图像间的像素位移情况,引入三维卷积核提取序列图像特征,提出了一种快速的端到端多流光场深度估计网络。在光场数据集New HCI上的测试显示所提光场深度估计网络在BP、MSE和计算时间3个性能指标上优于现有光场深度估计方法,有效提高了网络预测深度的性能,且对遮挡严重的Boxes等场景的测试也表明所提算法有较强的鲁棒性。消融实验表明,所提出的Mix Attention注意力机制充分挖掘了不同通道邻域像素间的相关性,有效提高了光场深度估计网络预测深度的性能。但是对于缺少纹理信息的区域,所提方法表现欠佳。下一步,将重点研究利用空间金字塔等结构增加网络对多尺度特征的提取能力,通过平滑对无纹理区域的深度结果进行优化,进一步提高深度估计可靠性。

(文章来源于光电工程,如有侵权,请联系删文)