- 07/17

- 2025

-

QQ扫一扫

-

Vision小助手

(CMVU)

摘要

本文提出一种基于深度学习的三维视觉引导机械臂物流分拣方法,旨在解决传统分拣系统在复杂场景下识别精度低、适应性差的问题。通过融合三维视觉技术与深度学习算法,系统实现对物流物品的高精度三维建模与特征提取,结合强化学习策略优化机械臂的运动轨迹规划,显著提升分拣效率与准确性。实验结果表明,该方法在动态环境下分拣错误率降低,同时具备对不同尺寸、形状物品的快速适应能力,可广泛应用于智能仓储、自动化生产线等场景,为物流智能化升级提供技术支撑。

Abstract

This paper proposes a logistics sorting method based on deep learning and 3D vision-guided robotic arms, aiming to address the limitations of traditional sorting systems in complex environments, such as low recognition accuracy and poor adaptability. By integrating 3D vision technology with deep learning algorithms, the system achieves high-precision 3D modeling and feature extraction of logistics items, combined with reinforcement learning strategies to optimize robotic arm motion trajectory planning, significantly enhancing sorting efficiency and accuracy. Experimental results demonstrate that the method reduces sorting error rates in dynamic environments,while maintaining rapid adaptability to items of varying sizes and shapes. The method is applicable to intelligent warehousing, automated production lines, and other scenarios, providing technical support for the intelligent upgrading of logistics systems.

关键词

深度学习;3D视觉;轨迹引导;特征提取

Keywords

Deep Learning,3D Vision,Guided,Feature extraction

一、引言

在快递业高速发展的今天,国内每天需要运送的包裹数以亿计,其中分拣工作最为繁琐,但也是整个物流配送过程中的重要工作,直接影响着物流效率。传统的人工分拣效率低、成本高、招工难、工作时间长等情况,同时面临劳动力人口数量及占比双降,因此选择自动化分拣成为必然。

自动化分拣主要包括目标分割及定位抓取两大操作,但是在物流包裹分拣场景中,面临着包裹种类多、堆叠复杂等问题,且分拣工作所处环境复杂,容易对自动分拣设备造成干扰,从而影响包裹识别率,导致分拣效率低、设备适应性差,并且定位抓取时难以准确定位包裹真实位置,导致出现漏拣、包裹破损等情况。

二、技术背景

目标分割是物流包裹自动分拣系统的核心环节,现存方法包括了物理特性筛选、读码及传感感知。物理特征筛选即是通过目标的形状、重量等物理特性,设计对应的机械结构实现分类,该方法只能实现粗分离,难以实现对物流包裹的有效分割。读码的方法提高了智能化水平,将目标信息集成在码上,通过读码可以快捷获取到目标信息,实现目标分割。

但是面临当今包裹体量大、种类多等问题,不仅制码操作繁琐,而且在分拣流传输中,容易出现码破损,或者是被异物遮挡、重叠包裹遮挡等现象,导致读码失败,达不到预期的效果。基于传感感知的方法,包括激光雷达传感、视觉传感等,依靠高精度传感器实现对包裹信息的准确获取。激光雷达通过扫描包裹,获取其点云数据,进而实现目标分类,但该设备依赖与传感器本身的精度,成本过高。人的视觉信息占人获取的信息的约80%,可见视觉蕴含着丰富的信息。使用相机的成本并不高,并且还能提供丰富的目标信息,因此使用视觉传感进行目标分割成为了当今主流技术。随着深度学习在图像分割领域的发展,基于二维图像的深度学习分割方法已经能够实现高精度的分割。但是二维处理没有考虑物体空间信息,难以实现对堆叠包裹的有效区分,因此三维视觉技术成为解决堆叠包裹区分的突破口。

对于包裹分拣,在目标分割后,还需要进行机械臂的定位抓取操作,该操作是实现自动化分拣必不可少的执行环节。对于使用相机的机械臂来讲,首先问题是确定相机与机械臂的配置方式。常用视觉配置方式包括Eye-in-Hand、Eye-on-Hand、Fixed Camera、Hybrid Configuration。各方法各有优劣,对于包裹分拣物流台,难以找到在机械臂之外用于固定相机的位置,而将相机安装在机械臂末端时,难以调整相机与末端执行器之间的位置关系。Eye-on-Hand将相机固定在机械臂非末端位置,可以有效解决上述问题。

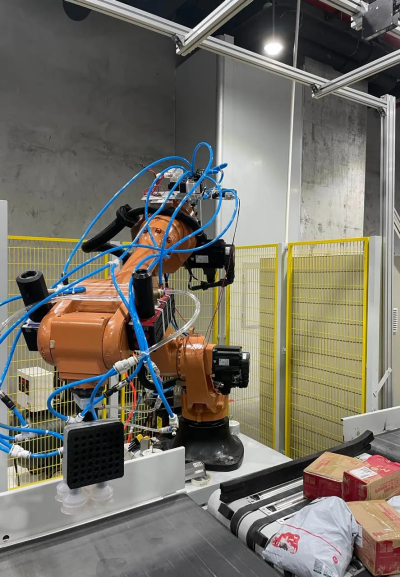

基于上述分析,我们提供了一种基于深度学习的三维视觉引导机械臂自动物流分拣方法,搭建了使用该方法的相机、机械臂等配套系统(图1所示)。该系统主要功能模块由双目散斑结构光3D相机、六轴机械臂组成,其中机械臂欧拉角旋转类型为内旋,旋转顺序为XYZ,相机与机械臂的位置关系为Eye-to-Hand式。

图1 3D视觉抓取机器人

三、视觉系统

通过采集获取的RGBD图像,利用深度学习的图像分割及目标物体三维深度信息,有效解决了包裹多样性、复杂堆叠等难拣问题,提高了分拣的鲁棒性。同时,通过优化机械臂的抓取位姿、优化机械臂轨迹规划提高分拣效率,优化不同种类包裹的吸力、优化机械臂运动控制降低包裹的破损率。视觉系统工作流程如下:

3D视觉系统构成:3D视觉系统由安装在机器人末端法兰的双目工业相机、数据采集卡及视觉软件组成。

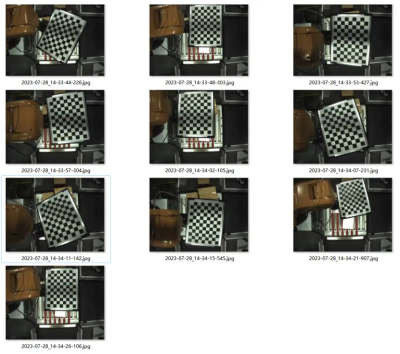

手眼标定:确认工业相机的摆放位置及方式(眼在手上/眼在手外),与镜头焦距及检测产品范围相关。通过视觉软件进行手眼标定,将相机坐标系与机械臂坐标系关联。使用高精度标定板,相机采集机械臂不同位姿下标定板的图像(如图2所示),图像需要与机械臂位姿一一对应,软件计算两个坐标系间的变换关系,并输出误差供用户确认。

图2 采集标定板图像

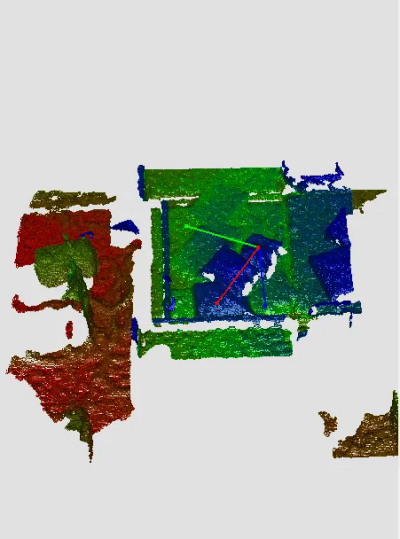

图像分割与位姿计算:采集物流线上的包裹图像,使用预先训练的分割模型进行实例分割。提取图像中的深度信息,进行点云提取,计算包裹抓取点及对应位姿。

视觉通讯流程:包裹计算的3D信息(XYZ、ABC)与机械臂坐标保持一致(如图3所示)。并将计算结果通讯发送给机械臂,完成整个视觉通讯流程。

图3 包裹计算中心点及位姿

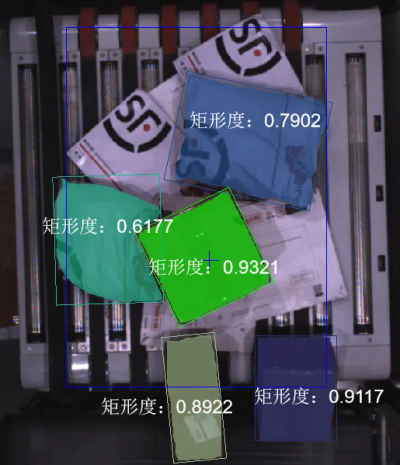

整体工作流程效果如图4所示,在一堆无序摆放的包裹中,根据软件算法分割计算当前最优抓取目标以及对应目标位姿,发送信号和数据给机械臂控制计算机,以便机械臂依次完成抓取搬运包裹。

图4 整体工作过程图

四、优化策略

在处理过程中,我们对模型处理后区域边缘出现的锯齿现象进行了优化,通过细化插值边缘和区域腐蚀等技术手段,改善了分割结果。

面对大量包裹堆叠的情况,模型的分割效果并不理想。基于此,我们结合了设计的顶层优先抓取策略,通过计算实例分割后每个区域的外接矩形中点,并利用双目散斑结构光3D相机获取的深度信息,对区域包裹按高度进行排序。随后,结合矩形度策略,筛选出顶层完整的待抓取包裹(如图5所示)。

为了降低包裹破损率,机械臂必须精确获取待抓取包裹的抓取点位置及抓取位姿。我们对3D相机获取的待抓取包裹深度信息进行点云提取,运用RANSAC算法拟合点云平面,计算出该平面上的中心点及法向位置,进而确定机械臂抓取包裹时的位姿。同时,我们针对不同类型的包裹制定了相应的抓取策略:信封抓取时速度较快、吸力较小、压力较小;软包抓取时速度较慢、吸力较大、压力较大;箱体抓取时速度较慢、吸力较大、压力较小,以实现高精度且无破损的抓取效果。

图5 处理后的顶层待抓取包裹