- 03/11

- 2022

-

QQ扫一扫

-

Vision小助手

(CMVU)

随着机器人的应用版图从工厂不断扩张到商场、超市等服务领域,面对的作业环境也越来越复杂,对于产品的安全性、可靠性、智能化等要求明显提高,而机器人要应对这一变化,首先要做的不是对系统盲目的做加法,而是需要提升环境感知能力,构建一张更“完美”的地图。

长期以来,机器人使用的地图主要为传统的2D栅格地图、拓扑地图,用来指导机器人完成定位、导航、路径规划等任务,但这类地图缺乏机器人用于理解环境、人机/物机交互等业务逻辑的高层次语义信息,使得机器人在智能避障、识别、交互方面有着天然劣势,整体智能化水平不高,导航地图亟待升级。

以应用在商超、餐厅等场景下的服务机器人为例,场景特征主要为人员密集,且环境复杂度高,机器人作业时不仅要与人频繁交互,还需要应对密集的流动人群,不断进行动态避障或急停等安全规避动作,要高效完成这些基于环境变化、目标需求产生的实时性任务,意味着机器人不仅要能“看到”,还要能“看懂”,对周围环境做到“了然于心”,栅格地图、拓扑地图显然已无法满足要求。

而要解决这类地图问题,构建一张包含3D信息、环境语义的3D语义地图显得越发关键。

与传统地图相同,3D语义地图同样用于机器人的基础导航,不同的是,它的地图模型是针对真实场景的三维环境重构,包含区域性场景信息及场景中每个独立物体的属性信息、空间中的三维模型、位姿信息等,使机器人在语义层次上理解环境信息,模仿人类大脑对环境理解的方式,从而为实现更高层次的智能化操作提供有效支持。

INDEMIND 3D语义地图构建技术“无所不包”

解决感知问题是构建3D语义地图的前提,因此,目前的3D语义地图构建技术在技术实现上大多采用“多线激光雷达+视觉/ToF/其他传感器”的融合方案,以此提升环境感知能力,实现3D语义地图构建,但缺点是成本高昂,加之三维识别算法,场景切割,导致系统复杂性较高。而INDEMIND 3D语义地图构建在技术实现上则采用单视觉(双目)sensor方案,借助算法优势,即可输出媲美甚至超越激光融合方案的完整的场景3D语义信息。

图片来自网络

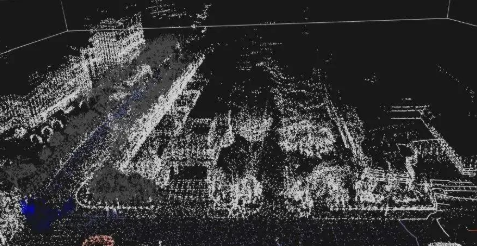

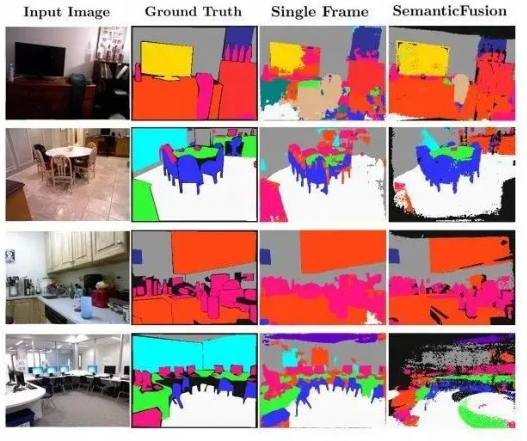

INDEMIND 3D语义地图构建是基于INDEMIND自研的立体视觉技术,通过对双目视觉传感器获取到3D视觉点云信息进行点云聚类,并结合边缘端的嵌入式深度学习和VSLAM算法,可快速输出个体性物体语义和区域性场景语义,实现3D语义地图构建。通过结合INDEMIND智能决策引擎,可实现智能避障、小区域局部作业、识别及人机/物机交互等各种高层次智能逻辑。

此外,由于真实场景中,无论是家庭、公司还是超市,大多拥有着3个及3个以上的细分场景,这意味着当机器人收到指定房间作业任务后需要快速准确地理解房间的功能属性,找到对应房间,并能根据不同房间的功能属性进行个性化作业。

图片来自网络

因此,为了保证场景理解的准确度,根据输出的区域性场景语义和个体性物体语义,INDEMIND采用二者融合的方式实现场景理解。首先,根据获取到的区域性场景语义信息,进行整体特征识别;其次,会根据个体性物体语义识别,对场景中一系列独立个体信息进行识别,并作为场景特征标志,最终通过二相叠加判断,实现场景理解。

需要提到的是,目前在扫地机器人上应用较为普遍的“单线激光雷达+视觉传感器”的融合方案,虽然也能获取到场景中的语义信息,但受限于传感器限制,事实上只能识别到物体的二维信息,无法构建3D语义地图。

识别、避障、交互?3D语义地图为机器人提供无限可能

INDEMIND 3D语义地图构建技术,除了能够为机器人的自主导航提供基础指导,更能为识别、智能避障、交互等智能化操作的深入化开发提供了可能性。

图片来自网络

基于INDEMIND立体视觉技术的区域性场景语义和个体化物体语义技术,能够快速提取环境中各类图像特征,结合深度学习可立体识别行人、动物、固定/移动物体等个体性障碍物,以及楼梯、自动扶梯等危险场景,避免危险情况发生,如去年发生的机器人扶梯跌落事件。

同时,通过识别到与显示匹配的障碍物3D信息,机器人可作出类似人类规避动作的精细化操作,能够让机器人有预判、有策略的实现智能避障。

此外,3D语义地图通过对场景中独立个体、房间信息做语义识别及物体分割,在交互上同样能够实现精细化操作,以现有的扫地机器人为例,它的智能程度相对仍然较低,还停留在一些基础的图像识别和语音交互上,对于个性化的交互实现较粗糙,无法实现独立的桌椅清扫等精细化交互,而3D语义地图则为机器人人机/物机交互的深入升级提供了真实可操作性,如实现目标跟踪、局部清扫等。